python网络爬虫,从根底到实践

当然能够,我能够协助你了解网络爬虫的基本概念和怎么运用 Python 来编写简略的网络爬虫。网络爬虫(也称为网页爬虫)是一种主动抓取网络数据的程序,它能够从互联网上获取信息并存储到本地。

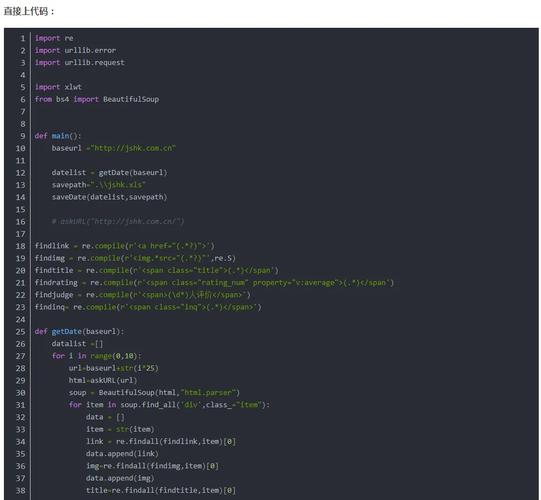

在 Python 中,有多个库能够协助你编写网络爬虫,比方 `requests`、`BeautifulSoup`、`Scrapy` 等。以下是一个简略的比方,展现了怎么运用 `requests` 和 `BeautifulSoup` 来抓取网页内容:

```pythonimport requestsfrom bs4 import BeautifulSoup

方针网页的 URLurl = 'http://example.com'

发送 HTTP 恳求response = requests.get

请留意,这仅仅一个十分简略的比方。在实践运用中,你或许需求处理更杂乱的状况,比方登录、处理动态内容、恪守网站的 `robots.txt` 规矩等。此外,网络爬虫或许会对网站形成担负,因此在编写爬虫时应该尊重网站的 `robots.txt` 文件,并防止对网站形成不必要的压力。

Python网络爬虫入门攻略:从根底到实践

一、什么是网络爬虫?

网络爬虫(Web Crawler)是一种主动抓取互联网上信息的程序。它经过模仿浏览器行为,拜访网页,解析网页内容,提取所需信息,并将这些信息存储起来。网络爬虫在搜索引擎、数据发掘、舆情剖析等范畴有着广泛的运用。

二、Python网络爬虫的优势

Python作为一种解说型、面向对象的编程言语,具有以下优势:

语法简洁明了,易于学习和运用。

具有丰厚的第三方库,如requests、BeautifulSoup、Scrapy等,便利网络爬虫的开发。

跨渠道性强,可在Windows、Linux、macOS等操作系统上运转。

三、Python网络爬虫的基本原理

Python网络爬虫的基本原理如下:

发送HTTP恳求,获取网页内容。

解析网页内容,提取所需信息。

存储提取到的信息。

四、Python网络爬虫开发过程

以下是一个简略的Python网络爬虫开发过程:

确认爬取方针:清晰需求爬取的网站和方针信息。

剖析网站结构:了解方针网站的URL规矩、页面结构等。

编写爬虫代码:运用Python编写爬虫程序,完成数据抓取。

测验和优化:测验爬虫程序,保证其正常运转,并依据实践状况进行优化。

五、Python网络爬虫实战事例

以下是一个简略的Python网络爬虫实战事例,用于抓取某个网站的新闻列表:

import requests

from bs4 import BeautifulSoup

def crawl_news(url):

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

news_list = soup.find_all('div', class_='news-item')

for news in news_list:

title = news.find('h2').text

link = news.find('a')['href']

print(title, link)

if __name__ == '__main__':

url = 'http://example.com/news'

crawl_news(url)

六、留意事项

在进行网络爬虫开发时,需求留意以下事项:

恪守方针网站的robots.txt规矩,尊重网站版权。

合理操控爬取频率,防止对方针网站形成过大压力。

处理异常状况,如网络恳求失利、解析过错等。

Python网络爬虫是一种强壮的数据抓取东西,能够协助咱们获取互联网上的信息。经过本文的介绍,信任您现已对Python网络爬虫有了开始的了解。在实践运用中,不断堆集经历,进步爬虫技术,才干更好地发挥网络爬虫的效果。