大数据集成,大数据集成的概述

大数据集成是将来自不同来历、格局和体系的数据整合到一个一致的视图或存储中,以便于剖析和使用。跟着数据量的不断增加和来历的多样化,大数据集成变得越来越重要。它能够协助企业从多个数据源中提取有价值的信息,支撑决议计划拟定、事务优化和猜测剖析。

大数据集成的关键过程包含:

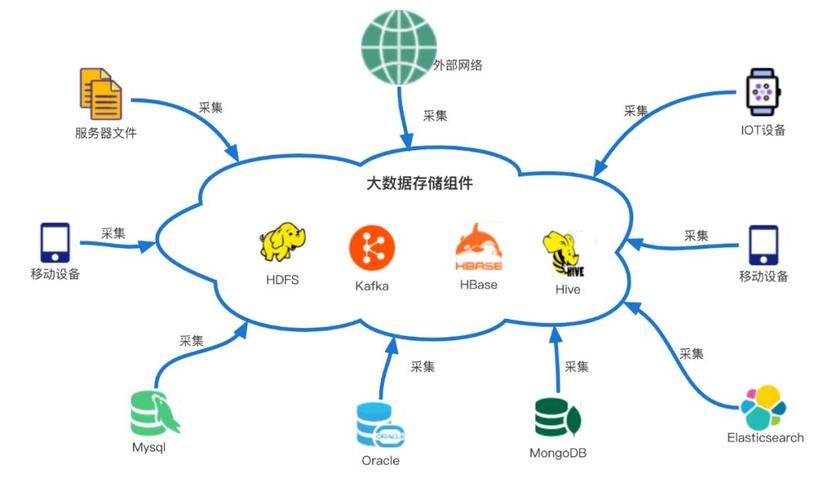

1. 数据源辨认:确认需求集成的数据源,包含内部数据(如数据库、文件体系)和外部数据(如交际媒体、传感器数据)。

2. 数据抽取:从数据源中提取数据,或许触及数据转化和清洗,以保证数据的质量和一致性。

3. 数据转化:将抽取的数据转化为一致的格局,以便于存储和剖析。这或许包含数据类型转化、数据格局化、数据映射等。

4. 数据加载:将转化后的数据加载到方针存储体系,如数据仓库、数据湖或数据湖仓。

5. 数据办理:在方针存储体系中办理数据,包含数据索引、数据分区、数据压缩等,以进步数据查询和处理的功率。

6. 数据办理:保证数据集成的合规性、安全性和隐私性,包含数据拜访操控、数据加密、数据审计等。

7. 数据剖析:使用集成的数据进行剖析,以发现事务洞悉、猜测趋势和优化决议计划。

大数据集成东西和技能:

1. ETL东西:Extract, Transform, Load 东西,用于从数据源中提取数据,进行转化,然后加载到方针存储体系。

2. 数据集成渠道:供给数据集成、数据转化、数据加载和数据办理功用的归纳渠道。

3. 数据虚拟化:答使用户拜访不同数据源中的数据,而无需将数据移动或复制到中心存储体系。

4. API集成:经过使用程序编程接口(API)将不同体系中的数据集成在一起。

5. 数据库衔接器:用于衔接不同数据库体系的东西,以便于数据抽取和加载。

6. 数据仓库:用于存储和办理结构化数据的中心存储体系,支撑杂乱的数据剖析和陈述。

7. 数据湖:用于存储和办理非结构化、半结构化数据的大容量存储体系,支撑大数据剖析和机器学习。

8. 数据湖仓:结合了数据仓库和数据湖的功用,支撑结构化和非结构化数据的存储和剖析。

大数据集成是一个杂乱的进程,需求考虑数据源多样性、数据质量、数据安全性和数据处理功率等要素。挑选适宜的大数据集成东西和技能,并拟定有用的数据集成战略,关于完成大数据的价值至关重要。

大数据集成的概述

跟着信息技能的飞速发展,大数据已经成为企业决议计划、创新和竞争力的重要资源。大数据集成作为大数据处理的第一步,旨在将来自不同来历、不同格局和不同结构的数据进行整合,为后续的数据剖析和发掘供给根底。本文将深化探讨大数据集成的概念、技能架构以及在实践使用中的应战和解决方案。

大数据集成的概念与重要性

大数据集成是指将涣散在不同数据源中的数据进行搜集、清洗、转化和加载的进程。这一进程关于企业来说至关重要,由于它能够:

打破数据孤岛,完成数据同享和协同。

进步数据质量,保证数据的一致性和准确性。

支撑杂乱的数据剖析和发掘,为事务决议计划供给有力支撑。

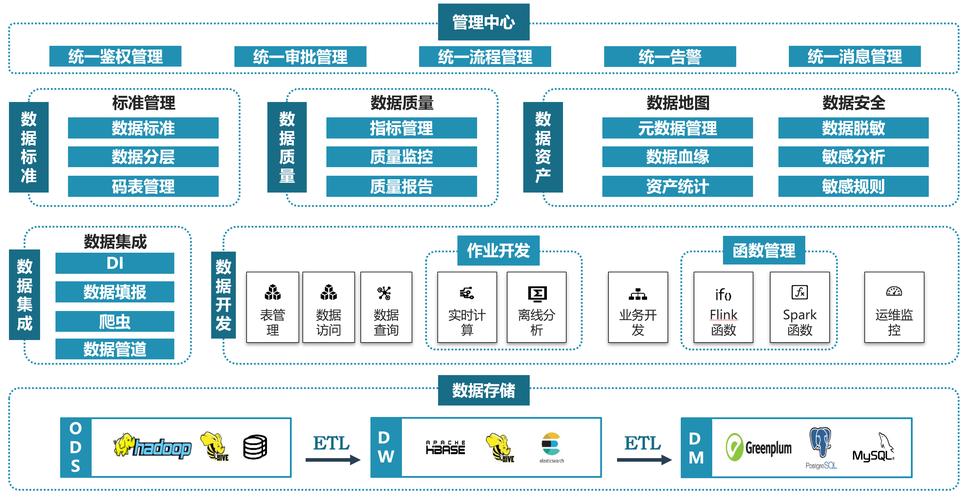

大数据集成的技能架构

ETL(Extract, Transform, Load)架构:ETL架构是传统的数据集成方法,它将数据从源体系中提取出来,经过转化处理后,再加载到方针体系中。ETL架构首要包含数据提取、数据转化和数据加载三个过程。

ELT(Extract, Load, Transform)架构:ELT架构与ETL架构相似,但在数据转化阶段有所不同。在ELT架构中,数据首要被加载到方针体系中,然后再进行转化处理。

数据仓库:数据仓库是企业级数据整合和剖析的柱石,它将来自不同数据源的数据进行整合,为事务剖析和决议计划供给支撑。

数据湖:数据湖是一种新式的大数据存储架构,它将原始数据存储在分布式文件体系中,以便进行后续的数据剖析和发掘。

大数据集成的关键技能

数据抽取技能:数据抽取技能用于从源体系中提取数据,常见的抽取技能包含增量抽取、全量抽取和根据规矩的抽取。

数据清洗技能:数据清洗技能用于处理和批改数据中的过错、缺失和异常值,以进步数据质量。

数据转化技能:数据转化技能用于将数据从一种格局转化为另一种格局,以满意事务需求。

数据加载技能:数据加载技能用于将清洗和转化后的数据加载到方针体系中,常见的加载技能包含批量加载和实时加载。

大数据集成的应战与解决方案

数据源多样性:不同数据源的数据格局、结构和质量各异,需求选用灵敏的数据集成技能。

数据质量:数据质量直接影响后续的数据剖析和发掘成果,需求树立数据质量办理体系。

功能优化:大数据集成进程中,数据量巨大,需求优化数据抽取、转化和加载等环节的功能。

安全性:数据集成进程中,需求保证数据的安全性,避免数据走漏和不合法拜访。

针对上述应战,能够采纳以下解决方案:

选用标准化数据格局和元数据办理,进步数据一致性。

引进数据质量评价和监控机制,保证数据质量。

优化数据集成流程,进步数据处理功率。

选用数据加密、拜访操控等技能,保证数据安全。

大数据集成是大数据处理的重要环节,关于企业来说具有至关重要的含义。经过深化了解大数据集成的概念、技能架构、关键技能以及应战与解决方案,企业能够更好地应对大数据年代的应战,完成数据价值的最大化。