数据库数据去重,数据库数据去重的重要性

数据库数据去重一般是指从数据库中删去重复的记载,保证每条记载都是仅有的。这能够经过多种办法完成,详细取决于你运用的数据库类型(如 MySQL、PostgreSQL、SQL Server 等)以及你希望去重的表和字段。

1. 运用 SQL 的 `DISTINCT` 关键字: 你能够运用 `SELECT DISTINCT` 句子来挑选仅有的记载。这种办法适用于简略的查询,但当需求去重多个字段时或许不行灵敏。

```sql SELECT DISTINCT column1, column2, ... FROM table_name; ```

2. 运用 `GROUP BY` 句子: 假如你想依据多个字段去重,能够运用 `GROUP BY` 句子。这将依据指定的字段对记载进行分组,并回来每个分组的聚合成果。

```sql SELECT column1, column2, ... FROM table_name GROUP BY column1, column2, ...; ```

3. 运用暂时表或子查询: 你能够创立一个暂时表或子查询来存储仅有的记载,然后从原始表中删去重复的记载。

```sql CREATE TEMPORARY TABLE temp_table AS SELECT DISTINCT FROM original_table;

DELETE FROM original_table WHERE NOT EXISTS ; ```

4. 运用数据库的特定功用: 一些数据库供给了特定的功用来处理数据去重。例如,SQL Server 的 `ROW_NUMBER` 函数能够用于标识重复的记载,然后你能够依据这些标识来删去重复项。

```sql WITH RankedRecords AS OVER qwe2 AS rn FROM table_name qwe2 DELETE FROM RankedRecords WHERE rn > 1; ```

5. 运用运用程序逻辑: 在某些情况下,你或许需求在运用程序层面处理数据去重。这一般涉及到从数据库中检索数据,然后在内存中比较记载,以辨认和删去重复项。

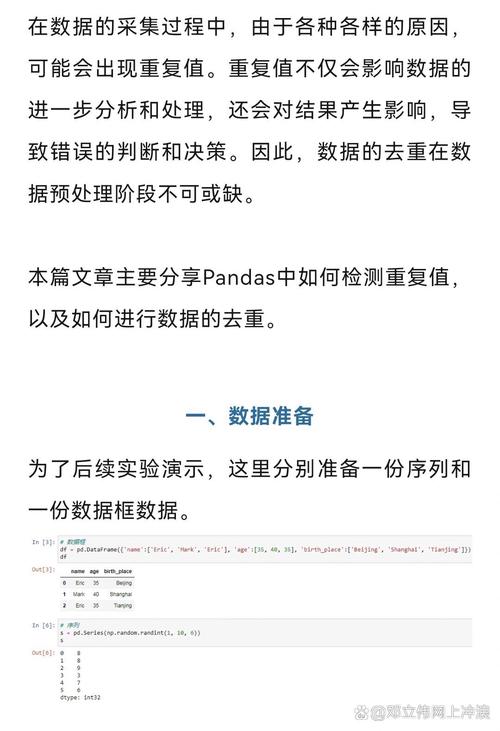

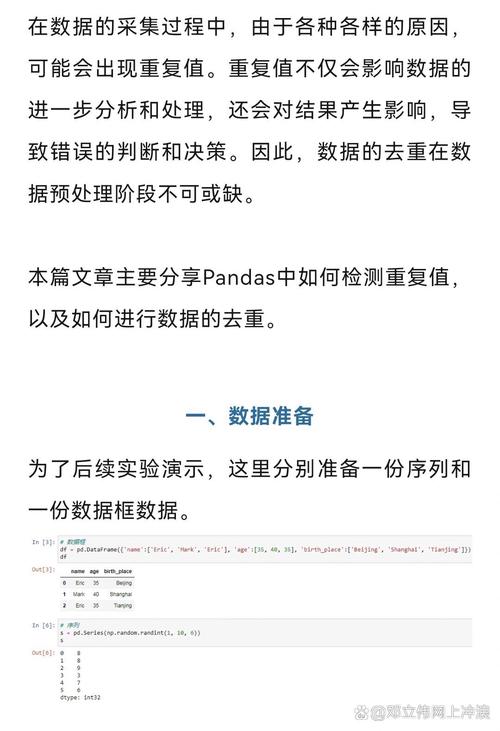

```python Python 示例 import pandas as pd

假定 df 是一个包括重复数据的 DataFrame df_unique = df.drop_duplicatesqwe2 ```

请留意,在进行数据去重之前,保证你了解去重对事务逻辑和数据完整性的影响。在某些情况下,重复的记载或许是有意义的,例如在处理时刻序列数据时。此外,在履行删去操作之前,最好先备份你的数据,以防万一。

数据库数据去重的重要性

在数据库办理中,数据去重是一个至关重要的进程。跟着数据量的不断增加,重复数据不只会占用额定的存储空间,还会影响查询功率,乃至或许导致数据剖析和决议计划的误差。因而,了解数据库数据去重的重要性是每个数据库办理员和开发人员的基本技能。

什么是数据去重

数据去重,望文生义,便是辨认并删去数据库中重复的数据记载。这些重复的数据或许因为数据录入过错、数据同步问题或数据导入时的重复操作等原因发生。

数据去重的类型

数据去重能够分为以下几种类型:

完全去重:删去一切重复的数据记载,只保存一个。

部分去重:只删去部分重复的数据记载,例如保存最新的记载。

根据特定字段的去重:只针对数据库中特定字段进行去重操作。

数据去重的办法

以下是几种常见的数据去重办法:

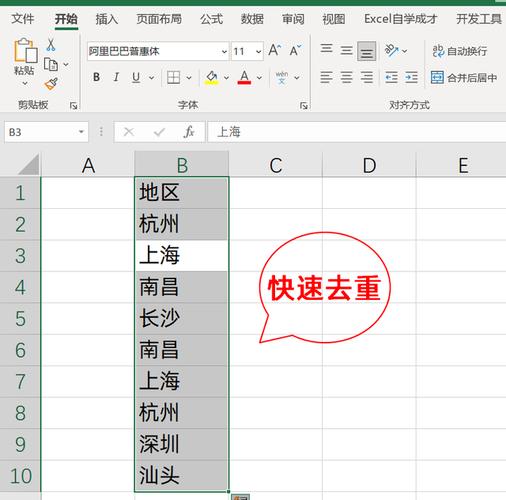

1. SQL句子去重

运用SQL句子中的DISTINCT关键字能够轻松地对数据库进行去重操作。以下是一个简略的示例:

SELECT DISTINCT column1, column2 FROM table_name;

2. 运用数据库东西

许多数据库办理体系(DBMS)都供给了内置的去重东西,如MySQL的GROUP_CONCAT()函数、Oracle的DISTINCT函数等。

3. 编写脚本去重

关于杂乱的数据去重需求,能够编写脚本来自动化去重进程。例如,运用Python的pandas库能够轻松处理大型数据集的去重。

import pandas as pd

读取数据

data = pd.read_csv('data.csv')

去重

data_unique = data.drop_duplicates()

保存去重后的数据

data_unique.to_csv('data_unique.csv', index=False)

数据去重的留意事项

在进行数据去重时,需求留意以下几点:

保证去重操作不会影响事务逻辑,例如,某些事务场景或许需求保存重复数据。

在去重前备份原始数据,以防万一。

关于杂乱的去重需求,主张先在测验环境中进行验证。

数据库数据去重是数据库办理中的一个重要环节,能够有用进步数据库功能和准确性。把握数据去重的办法和留意事项,有助于数据库办理员和开发人员更好地保护数据库。

数据库数据去重 数据库办理 数据清洗 数据去重办法 数据库功能