python爬虫库,高效数据抓取的利器

深化解析Python爬虫库:高效数据抓取的利器

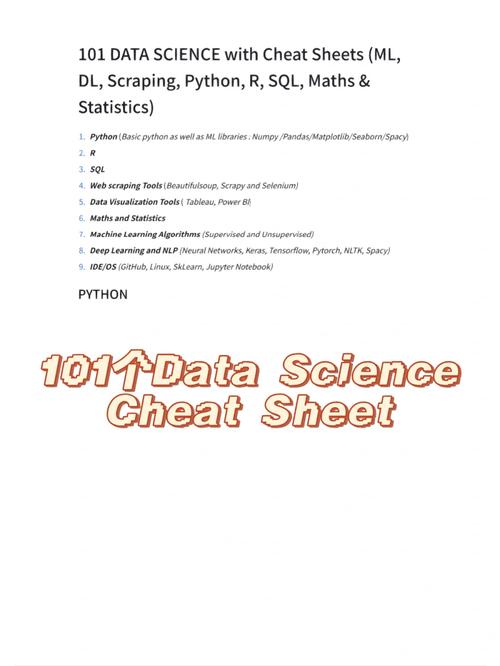

在互联网年代,数据已成为企业决议计划和科研立异的重要资源。Python作为一种功用强壮的编程言语,凭仗其简练的语法和丰厚的库资源,在数据抓取范畴发挥着重要作用。本文将深化解析Python爬虫库,协助读者了解怎么高效地进行数据抓取。

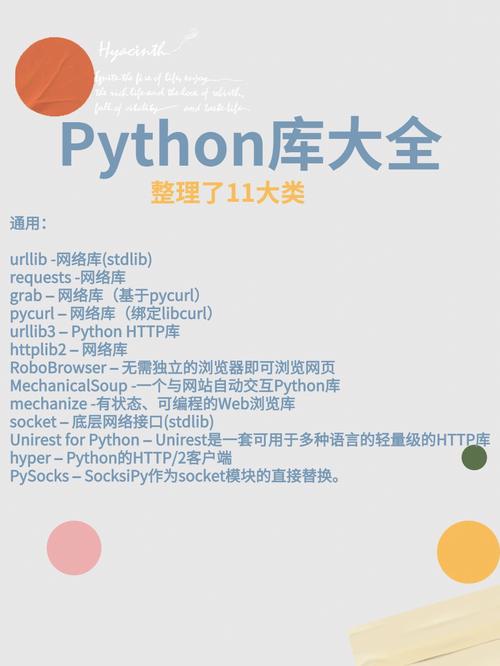

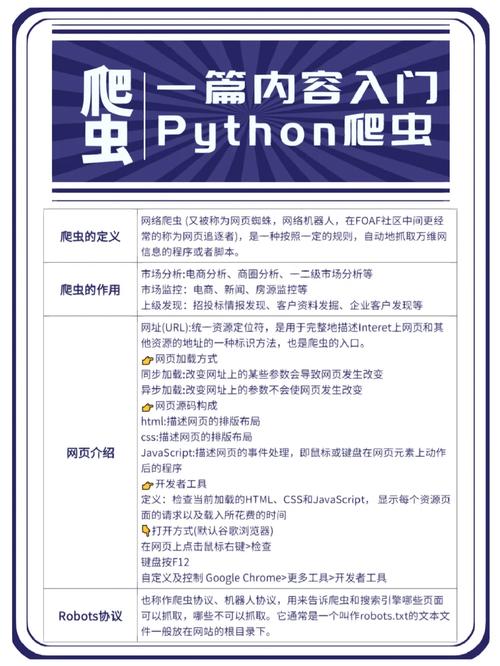

一、Python爬虫库概述

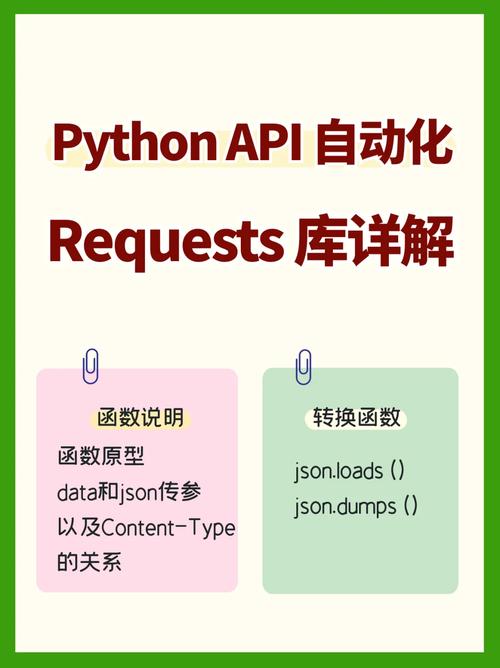

1. requests

requests库是Python中最常用的HTTP库之一,它供给了发送HTTP恳求、处理呼应等功用。运用requests库,能够轻松地发送GET、POST、PUT、DELETE等恳求,并获取呼应内容。

2. BeautifulSoup

BeautifulSoup库是一个用于解析HTML和XML文档的库,它将HTML或XML文档转化成一个杂乱的树形结构,然后能够方便地提取所需信息。BeautifulSoup支撑多种解析器,如lxml、html5lib等。

3. Scrapy

Scrapy是一个快速、高层次的屏幕抓取和网页爬取结构,它支撑异步处理和分布式爬虫。Scrapy具有强壮的功用,如主动处理HTTP恳求、主动解析呼应、主动存储数据等,十分合适处理大规模数据抓取使命。

4. Selenium

Selenium是一个主动化测验东西,但它也能够用于爬虫开发。Selenium能够模仿浏览器行为,如点击、输入、翻滚等,然后获取动态加载的网页内容。这关于爬取JavaScript烘托的网页十分有用。

5. Pandas

Pandas是一个强壮的数据剖析库,它供给了丰厚的数据结构和数据剖析东西。在爬虫过程中,能够运用Pandas对抓取到的数据进行清洗、转化和剖析。

二、Python爬虫库的运用方法

以下是一个简略的Python爬虫示例,展现了怎么运用requests和BeautifulSoup库抓取网页数据:

```python

import requests

from bs4 import BeautifulSoup

发送GET恳求获取网页内容

url = 'https://www.example.com'

response = requests.get(url)

解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

提取所需信息

title = soup.find('title').text

print('网页', title)

提取一切链接

links = soup.find_all('a')

for link in links:

print('', link.get('href'))

三、Python爬虫库的优化技巧

1. 运用署理IP

运用署理IP能够防止IP被封禁,进步爬虫的稳定性。能够运用第三方署理IP服务或自己建立署理服务器。

2. 约束恳求频率

合理设置恳求频率,防止对方针网站形成过大压力。能够运用time模块完成延时恳求。

3. 并发处理

运用多线程或多进程技能,进步爬虫的并发处理才能。Scrapy结构支撑异步处理,能够充分利用系统资源。

4. 数据存储

合理挑选数据存储方法,如CSV、JSON、数据库等。关于大规模数据,主张运用数据库存储。

Python爬虫库为数据抓取供给了强壮的支撑,经过合理挑选和运用这些库,能够高效地获取所需数据。在编写爬虫程序时,留意恪守相关法律法规和网站方针,尊重别人知识产权。