网络爬虫python代码, Python 网络爬虫 数据抓取 Scrapy BeautifulSoup

当然能够。网络爬虫是一个主动化程序,用于从网站或其他网络资源中提取信息。Python是一种盛行的编程言语,用于创立网络爬虫,由于它具有强壮的库,如`requests`和`BeautifulSoup`,这些库能够轻松地发送HTTP恳求和解析HTML内容。

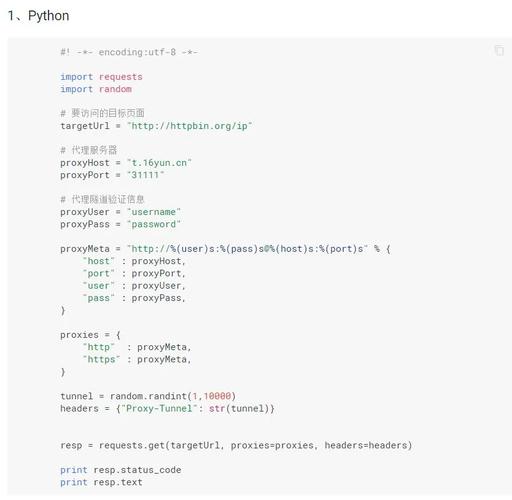

下面是一个简略的网络爬虫示例,它运用`requests`库来发送HTTP恳求,并运用`BeautifulSoup`库来解析HTML内容。这个爬虫将从一个网站获取一切链接的列表:

```pythonimport requestsfrom bs4 import BeautifulSoup

def get_links: response = requests.get soup = BeautifulSoup links = for link in soup.find_all: href = link.get if href: links.append return links

运用示例url = 'http://example.com'links = get_linksprint```

请注意,这个示例十分简略,而且没有考虑许多实践网络爬虫中需求处理的问题,例如错误处理、并发恳求、恪守robots.txt文件等。此外,依据您要爬取的网站和内容,或许需求运用不同的办法和技能。

假如您有特定的网站或内容需求爬取,请供给更多信息,以便我能够为您供给更详细的协助。

Python网络爬虫实战教程:从入门到实践

Python 网络爬虫 数据抓取 Scrapy BeautifulSoup

二、Python网络爬虫的根本概念

网络爬虫(又称网页蜘蛛、网络机器人)是一种模仿浏览器发送网络恳求,接纳恳求呼应,依照必定规矩主动抓取互联网信息的程序。爬虫的作业流程一般包含以下过程:

获取资源地址:爬虫首要要获取方针数据的资源地址,即URL。

获取网页源代码:经过HTTP恳求获取网页的源代码,源代码中包含了网页的部分有用信息。

解析网页源代码:运用正则表达式、BeautifulSoup、pyquery等东西解析网页源代码,提取所需数据。

提取数据:将解析后的数据提取出来,并保存到指定的格局,如TXT、JSON、数据库等。

保存数据:将提取到的数据保存到本地或长途服务器,以便后续运用。

三、Python网络爬虫的根本流程

下面以一个简略的比如,展现Python网络爬虫的根本流程。

1. 装置Scrapy结构

Scrapy是一个用Python编写的开源网络爬虫结构,用于高效地从网站上抓取信息并提取结构化数据。首要,咱们需求装置Scrapy结构。

pip install scrapy

2. 创立Scrapy项目

创立一个Scrapy项目,用于寄存爬虫代码和相关装备。

scrapy startproject myproject

3. 编写爬虫代码

在myproject目录下,创立一个名为spiders的文件夹,并在该文件夹中创立一个名为example.py的文件,用于编写爬虫代码。

import scrapy

class ExampleSpider(scrapy.Spider):

name = 'example'

start_urls = ['http://example.com']

def parse(self, response):

for sel in response.xpath('//div[@class=\